Το 2025 εξελίσσεται στο έτος κατά το οποίο οι AI agents πέρασαν από τη θεωρητική συζήτηση στη μαζική, πραγματική χρήση σε επιχειρησιακά περιβάλλοντα. Παράλληλα, νέα στοιχεία από τη Lakera, εταιρεία του ομίλου Check Point Software Technologies, δείχνουν ότι οι κυβερνοεπιτιθέμενοι αναγνώρισαν άμεσα αυτή τη μετάβαση και προσαρμόστηκαν με ανησυχητική ταχύτητα.

Σύμφωνα με νέα ανάλυση της Lakera, η οποία βασίζεται σε πραγματική επιθετική δραστηριότητα που παρατηρήθηκε κατά το τέταρτο τρίμηνο του 2025, μόλις τα συστήματα τεχνητής νοημοσύνης άρχισαν να περιηγούνται στο διαδίκτυο, να αναλύουν έγγραφα και να αλληλεπιδρούν με εξωτερικά εργαλεία, οι αντίπαλοι εξέλιξαν τις τεχνικές τους ώστε να εκμεταλλευτούν αυτές ακριβώς τις δυνατότητες.

Τα ευρήματα καταδεικνύουν ότι οι επιθέσεις δεν βασίζονται πλέον σε απλές ή «ωμές» μορφές prompt injection. Αντίθετα, οι επιτιθέμενοι στρέφονται σε έμμεσες επιθέσεις, οι οποίες ενσωματώνονται διακριτικά σε έγγραφα, ιστοσελίδες και δομημένο περιεχόμενο. Οι μέθοδοι αυτές απαιτούν λιγότερες προσπάθειες και εμφανίζουν σημαντικά υψηλότερα ποσοστά επιτυχίας.

Η έρευνα της Lakera αναδεικνύει τρεις κρίσιμες τάσεις που αναμένεται να καθορίσουν την ασφάλεια των AI συστημάτων το 2026:

- Η διαρροή system prompts αναδεικνύεται στον βασικό στόχο των επιτιθέμενων, με υποθετικά σενάρια και συγκαλυμμένα prompts να αποδεικνύονται ιδιαίτερα αποτελεσματικά.

- Οι παρακάμψεις μηχανισμών content safety γίνονται ολοένα και πιο λεπτές, συχνά εμφανιζόμενες ως ανάλυση, αξιολόγηση ή role-play αντί για εμφανώς κακόβουλα αιτήματα.

- Εξειδικευμένες επιθέσεις σε AI agents έχουν ήδη καταγραφεί, περιλαμβάνοντας προσπάθειες εξαγωγής εμπιστευτικών δεδομένων, εισαγωγής script-like οδηγιών και χειραγώγησης agents μέσω μη αξιόπιστων εξωτερικών πηγών.

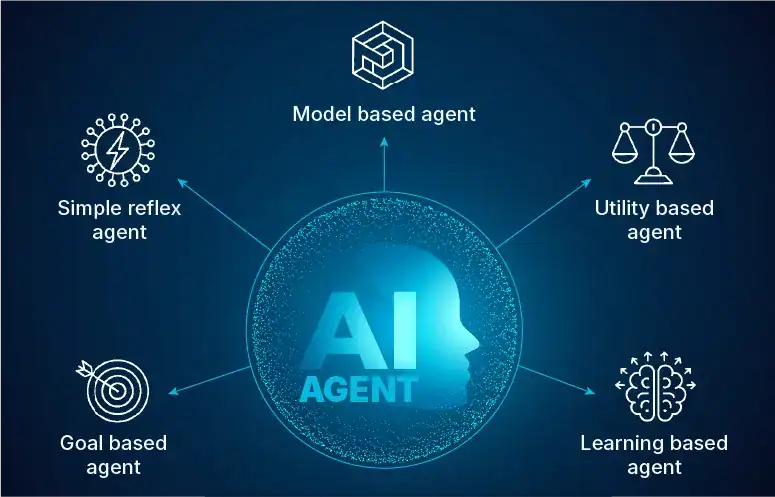

Σύμφωνα με τη Lakera, τα ευρήματα προσφέρουν μία από τις πρώτες και πιο ξεκάθαρες εικόνες για το πώς πραγματικοί επιτιθέμενοι ανταποκρίνονται στην υιοθέτηση agentic AI σε περιβάλλοντα παραγωγής. Οι AI agents εισέρχονται στους χώρους εργασίας ταχύτερα απ’ ό,τι μπορούν να προσαρμοστούν τα παραδοσιακά μοντέλα ασφάλειας. Η ίδια αυτοματοποίηση που υπόσχεται αυξημένη παραγωγικότητα διευρύνει, ταυτόχρονα και συχνά αθόρυβα, την επιφάνεια επίθεσης.

Παράλληλα, η έρευνα εγείρει σοβαρά ερωτήματα σχετικά με το πώς οι οργανισμοί θα διαχειριστούν με ασφάλεια την επεξεργασία εξωτερικού περιεχομένου, πηγών δεδομένων και εγγράφων από AI agents, ιδίως σε ρυθμιζόμενα και ευαίσθητα περιβάλλοντα. Όπως καταδεικνύουν τα δεδομένα του Q4 2025, το έμμεσο prompt injection δεν αποτελεί πλέον θεωρητικό κίνδυνο, αλλά μια ήδη πιο εύκολη και αποτελεσματική μορφή επίθεσης σε σύγκριση με τις άμεσες τεχνικές.

Η Lakera επισημαίνει ότι οι οργανισμοί που σχεδιάζουν να αναπτύξουν ή να επεκτείνουν τη χρήση AI agents το 2026 οφείλουν να επανεξετάσουν άμεσα τα όρια εμπιστοσύνης, τις διαδικασίες εισαγωγής εξωτερικών δεδομένων και τα προστατευτικά πλαίσια (guardrails), προκειμένου να διασφαλίσουν την ασφαλή υιοθέτηση της τεχνολογίας.

Η πλήρης έκθεση με τίτλο «The Year of the Agent – What Recent Attacks Revealed in Q4 2025 (and What It Means for 2026)» είναι διαθέσιμη, ενώ περισσότερες πληροφορίες παρουσιάζονται και στο σχετικό blog της Lakera.